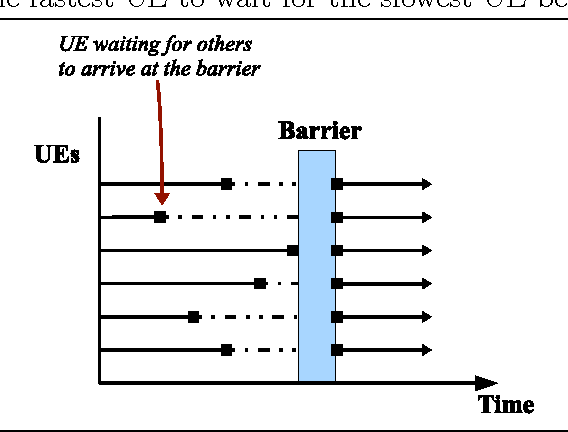

Das Barrier Pattern ist ein Entwurfsmuster, das in parallelen oder verteilten Systemen verwendet wird. Es wird eingesetzt, um mehrere Threads oder Prozesse zu synchronisieren, sodass sie auf einem bestimmten Punkt im Ablauf warten, bevor sie weiterarbeiten. Diese Technik wird häufig in Situationen verwendet, in denen mehrere Threads oder Prozesse auf eine bestimmte Bedingung oder ein Ereignis warten müssen, bevor sie gleichzeitig fortfahren können.

Grundprinzip des Barrier Pattern

Das Barrier Pattern definiert einen Synchronisationspunkt, an dem mehrere Threads oder Prozesse anhalten, bis alle eine bestimmte Phase erreicht haben. Erst wenn alle Teilnehmer diesen Punkt erreicht haben, wird der Ablauf fortgesetzt. Dies stellt sicher, dass alle beteiligten Threads oder Prozesse in einem synchronisierten Zustand sind und nicht eine der Entitäten vorzeitig weitermacht.

Ein Beispiel wäre ein System, in dem mehrere Threads gleichzeitig eine Reihe von Aufgaben durchführen, jedoch erst dann weitermachen können, wenn alle Threads ihre Aufgaben abgeschlossen haben. In diesem Fall wird das Barrier Pattern eingesetzt, um sicherzustellen, dass alle Threads gleichzeitig weiterarbeiten.

Beispiel des Barrier Pattern in C++

Im folgenden C++-Beispiel wird das Barrier Pattern verwendet, um mehrere Threads zu synchronisieren. Alle Threads warten an einem gemeinsamen Punkt, bevor sie mit der nächsten Operation fortfahren.

Schritt 1: Implementierung der Barrier-Klasse

#include <iostream>

#include <thread>

#include <vector>

#include <mutex>

#include <condition_variable>

class Barrier {

private:

int thread_count; // Anzahl der Threads, die warten müssen

int waiting_threads; // Anzahl der wartenden Threads

std::mutex mtx; // Mutex für die Synchronisation

std::condition_variable cv; // Bedingungsvariable für die Warteschlange

public:

// Konstruktor für das Barrier-Objekt

Barrier(int count) : thread_count(count), waiting_threads(0) {}

// Methode zum Warten auf das Barrier

void wait() {

std::unique_lock<std::mutex> lock(mtx);

++waiting_threads;

// Wenn alle Threads an der Barriere angekommen sind, fortfahren

if (waiting_threads == thread_count) {

waiting_threads = 0;

cv.notify_all(); // Alle Threads können fortfahren

} else {

cv.wait(lock); // Warten, bis alle Threads angekommen sind

}

}

};

Schritt 2: Nutzung der Barrier-Klasse im Hauptprogramm

void thread_task(int id, Barrier& barrier) {

std::cout << "Thread " << id << " startet die Aufgabe." << std::endl;

// Jede Aufgabe dauert eine zufällige Zeit

std::this_thread::sleep_for(std::chrono::seconds(1 + id % 3));

std::cout << "Thread " << id << " wartet an der Barriere." << std::endl;

barrier.wait(); // Warten an der Barriere

std::cout << "Thread " << id << " fährt fort." << std::endl;

}

int main() {

const int num_threads = 5;

Barrier barrier(num_threads);

std::vector<std::thread> threads;

// Threads starten

for (int i = 0; i < num_threads; ++i) {

threads.push_back(std::thread(thread_task, i + 1, std::ref(barrier)));

}

// Warten, bis alle Threads ihre Aufgaben abgeschlossen haben

for (auto& t : threads) {

t.join();

}

std::cout << "Alle Threads haben die Barriere überschritten und arbeiten weiter." << std::endl;

return 0;

}

Erklärung des Codes

In diesem Beispiel haben wir eine Barrier-Klasse, die eine Barriere für eine festgelegte Anzahl von Threads erzeugt. Jeder Thread führt eine Aufgabe aus, wartet dann an der Barriere und fährt fort, wenn alle Threads die Barriere erreicht haben. Die wait()-Methode sorgt dafür, dass Threads anhalten, wenn sie den Synchronisationspunkt erreichen, und nur weiterarbeiten, wenn alle Threads diesen Punkt erreicht haben.

Beispiel des Barrier Pattern in Python

Das Barrier Pattern ist ein Entwurfsmuster, das häufig in parallelen oder Multi-Threading-Szenarien verwendet wird. Es sorgt dafür, dass mehrere Threads bis zu einem bestimmten Punkt blockiert werden, bis alle Threads bereit sind, weiterzumachen.

In Python kann man das threading-Modul nutzen, um eine Barrier zu implementieren. Das Modul bietet eine eingebaute Barrier-Klasse, mit der man sicherstellen kann, dass mehrere Threads gleichzeitig auf einem bestimmten Punkt warten.

Hier ein einfaches Beispiel, wie das Barrier Pattern in Python umgesetzt wird:

import threading

import time

# Funktion, die von jedem Thread ausgeführt wird

def worker(barrier, thread_id):

print(f"Thread {thread_id} startet und wartet an der Barriere.")

# Warten, bis alle Threads den Barrierpunkt erreicht haben

barrier.wait()

print(f"Thread {thread_id} fährt fort.")

def main():

num_threads = 5 # Anzahl der Threads

# Erstelle eine Barrier, die auf die Anzahl der Threads wartet

barrier = threading.Barrier(num_threads)

threads = []

# Erstelle und starte die Threads

for i in range(num_threads):

t = threading.Thread(target=worker, args=(barrier, i))

threads.append(t)

t.start()

# Warten, dass alle Threads fertig sind

for t in threads:

t.join()

print("Alle Threads haben den Barrierpunkt erreicht und sind weitergegangen.")

if __name__ == "__main__":

main()Erklärung:

- Barrier: Wir erstellen eine

Barrier, die auf die Anzahl der Threads wartet. Sobald alle Threads diese Barriere erreichen, wird der Block gelöst, und alle Threads können fortfahren. - Thread-Start: In der

main-Funktion erstellen wir mehrere Threads, die jeweils dieworker-Funktion ausführen. - Barriere: Jeder Thread erreicht den Punkt

barrier.wait(), an dem er wartet, bis alle anderen Threads ebenfalls diesen Punkt erreicht haben. - Fortfahren: Sobald alle Threads an der Barriere angekommen sind, fahren sie alle gleichzeitig fort.

Beispiel-Ausgabe:

Thread 0 startet und wartet an der Barriere.

Thread 1 startet und wartet an der Barriere.

Thread 2 startet und wartet an der Barriere.

Thread 3 startet und wartet an der Barriere.

Thread 4 startet und wartet an der Barriere.

Thread 0 fährt fort.

Thread 1 fährt fort.

Thread 2 fährt fort.

Thread 3 fährt fort.

Thread 4 fährt fort.

Alle Threads haben den Barrierpunkt erreicht und sind weitergegangen.In diesem Beispiel wird sichergestellt, dass alle Threads gleichzeitig auf den gleichen Punkt (die Barriere) warten und dann gleichzeitig fortfahren.

Vorteile des Barrier Patterns

- Einfache Synchronisation: Das Barrier Pattern bietet eine einfache Möglichkeit, mehrere Threads oder Prozesse zu synchronisieren, ohne komplexe Logik oder manuelle Zustandsverfolgung.

- Verhindert Race Conditions: Da alle Threads oder Prozesse gleichzeitig an der Barriere anhalten und erst fortfahren, wenn alle synchronisiert sind, werden Race Conditions vermieden.

- Erhöht die Performance: In parallelen Systemen sorgt das Barrierenmuster dafür, dass alle Threads gleichzeitig fortfahren können, ohne unnötige Verzögerungen durch synchronisierte Warteschlangen.

- Verwendung in verteilten Systemen: Das Barrier Pattern ist in verteilten Systemen besonders nützlich, in denen mehrere Prozesse auf einem bestimmten Punkt warten müssen, bevor sie fortfahren können.

Nachteile des Barrier Patterns

- Blockierung von Threads: Während Threads auf den Synchronisationspunkt warten, sind sie blockiert. Dies kann in Systemen mit vielen Threads zu einer ineffizienten Ressourcennutzung führen.

- Komplexe Verwaltung in großen Systemen: In Systemen mit einer großen Anzahl von Threads kann die Verwaltung der Barriere und der wartenden Threads komplex und fehleranfällig werden.

- Mögliche Verzögerungen: Wenn ein Thread langsamer ist als die anderen oder nie die Barriere erreicht, kann das ganze System blockiert werden, was zu Verzögerungen führt.

- Nicht geeignet für alle Szenarien: Das Barrier Pattern eignet sich am besten für Szenarien, in denen eine genaue Synchronisation der Threads erforderlich ist. In weniger kritischen Szenarien kann es unnötig sein.

Was ist ein Barrier Prozess?

Ein Barrier-Prozess bezieht sich auf einen synchronisierten Mechanismus in parallelen und verteilten Systemen, bei dem mehrere Prozesse oder Threads an einem definierten Punkt (der „Barriere“) warten, bis alle anderen Prozesse oder Threads ebenfalls an diesem Punkt angekommen sind. Sobald alle Prozesse die Barriere erreicht haben, können sie gleichzeitig fortfahren.

Der Zweck eines Barrier-Prozesses ist es, eine Synchronisation oder Koordination zwischen den parallelen Prozessen zu gewährleisten, sodass diese nicht weiterlaufen, bevor alle anderen ebenfalls an einem bestimmten Punkt sind.

Anwendung:

- Parallelverarbeitung: Bei Aufgaben, die in mehreren Threads oder Prozessen gleichzeitig ausgeführt werden, können Barrieren dazu verwendet werden, sicherzustellen, dass jeder Prozess seine Aufgabe bis zu einem bestimmten Punkt abgeschlossen hat, bevor sie gleichzeitig mit der nächsten Phase fortfahren.

- Verteilte Systeme: In verteilten Systemen wird eine Barriere oft verwendet, um sicherzustellen, dass alle Knoten oder Prozesse in einem Netzwerk synchronisiert sind, bevor sie mit der nächsten Phase der Verarbeitung fortfahren.

Beispiel-Szenarien für einen Barrier-Prozess:

- Kollaboration von Threads: Bei der Verarbeitung eines großen Datensatzes durch mehrere Threads müssen diese möglicherweise synchronisiert werden, bevor sie ihre Ergebnisse zusammenführen können.

- Verteilte Berechnungen: In einer verteilten Anwendung, bei der mehrere Server Berechnungen durchführen, muss eine Barriere verwendet werden, um sicherzustellen, dass alle Server ihre Teilergebnisse berechnet haben, bevor sie mit der nächsten Phase der Verarbeitung fortfahren.

Wie funktioniert eine Barriere im Detail?

- Erreichen der Barriere: Jeder Prozess oder Thread muss die Barriere erreichen und an ihr warten.

- Warten: Alle Prozesse oder Threads warten, bis alle anderen ebenfalls die Barriere erreicht haben.

- Freigabe: Sobald der letzte Prozess die Barriere erreicht, wird die Barriere „freigegeben“, und alle wartenden Prozesse können gleichzeitig fortfahren.

Beispiele für Barrieren:

- Hardware: In einem Computer mit mehreren Kernen könnte eine Barriere dafür sorgen, dass alle Kerne die gleiche Phase eines Programms abgeschlossen haben, bevor sie mit der nächsten Phase fortfahren.

- Software: In verteilten Programmen oder bei Multithreading wird eine Barriere oft in Form eines Softwaremechanismus (wie das

Barrier-Objekt im Pythonthreading-Modul) implementiert.

Zusammengefasst ist ein Barrier-Prozess also ein Konzept, das dazu dient, mehrere parallele Prozesse zu koordinieren, indem sie darauf warten, dass alle an einem bestimmten Punkt in der Ausführung sind, bevor sie gemeinsam weitermachen können.

Was ist ein Barrier Type?

Ein Barrier Type bezeichnet eine spezifische Implementierung oder eine Variante des Barrier-Mechanismus, die für bestimmte Synchronisierungsanforderungen in parallelen oder verteilten Systemen entwickelt wurde. Verschiedene Barrier Types bieten unterschiedliche Synchronisierungsstrategien, um den Anforderungen von bestimmten Anwendungsfällen gerecht zu werden.

Im Allgemeinen unterscheidet man in der Parallelprogrammierung zwischen verschiedenen Arten von Barrieren, die je nach Nutzung und gewünschtem Verhalten unterschiedliche Eigenschaften besitzen. Zu den häufigsten Barrier Types gehören:

1. Hard Barrier (Feste Barriere)

- Beschreibung: Alle Threads oder Prozesse müssen die Barriere erreichen, bevor einer von ihnen fortfahren darf.

- Eigenschaften:

- Alle Threads müssen die Barriere erreichen, bevor irgendein Thread weiterlaufen kann.

- Dies stellt sicher, dass alle Threads synchron sind, bevor die Arbeit fortgesetzt wird.

- Wird häufig verwendet, wenn man sicherstellen muss, dass alle Threads oder Prozesse die gleiche Phase der Berechnung abgeschlossen haben, bevor sie weitermachen.

- Beispiel: In einem Map-Reduce-Algorithmus müssen alle Worker-Threads die Mappings abgeschlossen haben, bevor sie mit dem Reduce-Teil beginnen.

2. Soft Barrier (Weiche Barriere)

- Beschreibung: Bei einer weichen Barriere gibt es nicht notwendigerweise eine strikte Synchronisierung. Es kann vorkommen, dass einige Threads oder Prozesse vor anderen weiterarbeiten, solange dies keine inkonsistenten Zustände erzeugt.

- Eigenschaften:

- Ermöglicht eine gewisse Flexibilität, da nicht alle Threads gleichzeitig an der Barriere warten müssen.

- Wird in Szenarien verwendet, bei denen die Synchronisation nicht absolut strikt sein muss, sondern eher eine gewisse Entkopplung der Threads erwünscht ist.

- Kann auch in asynchronen Systemen oder bei unsynchronisierten Berechnungen verwendet werden, wo Threads nach Möglichkeit weiterarbeiten können.

- Beispiel: In einem real-time System, wo einige Threads auf ihre Daten warten müssen, aber andere Threads so schnell wie möglich weiterarbeiten dürfen.

3. Cyclic Barrier (Zyklische Barriere)

- Beschreibung: Ein zyklisches Barrier wird nach einer bestimmten Anzahl von Wiederholungen oder Iterationen zurückgesetzt, sodass ein Set von Threads die Barriere wieder durchlaufen kann, ohne das gesamte System zurückzusetzen.

- Eigenschaften:

- Ermöglicht es Threads, mehrfach hintereinander dieselbe Barriere zu passieren, was in langlaufenden oder iterativen Programmen nützlich ist.

- Häufig in Szenarien verwendet, in denen die Threads in mehreren Iterationen miteinander synchronisiert werden müssen.

- Die Barriere wird in jeder Runde zurückgesetzt, sodass alle Threads erneut darauf warten können, bis sie die Barriere erreichen.

- Beispiel: In einer Simulation, bei der die Threads in mehreren Iterationen synchronisiert werden, um fortlaufend zu arbeiten, ohne das gesamte System neu starten zu müssen.

4. Fault-Tolerant Barrier (Fehlertolerante Barriere)

- Beschreibung: Diese Barriere wurde so konzipiert, dass sie mit Fehlern in den beteiligten Threads oder Prozessen umgehen kann.

- Eigenschaften:

- Wird in Systemen verwendet, in denen Prozesse ausfallen können, ohne die gesamte Synchronisation zu beeinträchtigen.

- Die Barriere kann so gestaltet sein, dass sie weiterhin funktioniert, wenn nicht alle Threads erfolgreich teilnehmen.

- Nützlich in verteilten oder robusten Systemen, wo Fehler und Ausfälle von Prozessen erwartet werden.

- Beispiel: In einem verteilten Rechencluster, wo Knoten gelegentlich ausfallen können, aber die Berechnungen trotzdem fortgesetzt werden können.

5. Dynamic Barrier (Dynamische Barriere)

- Beschreibung: Eine dynamische Barriere kann sich während der Programmausführung ändern, je nachdem, wie viele Threads oder Prozesse daran teilnehmen müssen.

- Eigenschaften:

- Die Anzahl der Threads, die auf eine Barriere warten, ist nicht fest und kann sich zur Laufzeit ändern.

- Dies kann nützlich sein, wenn die Anzahl der Prozesse variabel ist oder sich während der Ausführung anpasst.

- Beispiel: In einem System, bei dem neue Threads dynamisch erstellt werden und die Barriere die Teilnahmezahl zur Laufzeit anpassen muss.

Beispiel in Python:

Das threading-Modul in Python verwendet eine Cyclic Barrier. Hier ein einfaches Beispiel, wie eine zyklische Barriere implementiert werden kann:

import threading

def worker(barrier, thread_id):

print(f"Thread {thread_id} wartet an der Barriere.")

barrier.wait()

print(f"Thread {thread_id} fährt fort.")

def main():

num_threads = 3

barrier = threading.Barrier(num_threads)

threads = []

for i in range(num_threads):

t = threading.Thread(target=worker, args=(barrier, i))

threads.append(t)

t.start()

for t in threads:

t.join()

if __name__ == "__main__":

main()

In diesem Beispiel wartet jeder Thread an der Barriere, bis alle Threads die Barriere erreicht haben, bevor sie gemeinsam fortfahren.

Ein Barrier Type bezieht sich auf die spezifische Art der Synchronisierung, die innerhalb einer Barriere verwendet wird. Die Wahl des Barrier-Typs hängt von den Anforderungen der Parallelisierung und den Synchronisationsbedürfnissen der Anwendung ab. Barrieren können strikt sein (z. B. Hard Barrier) oder flexibler gestaltet werden (z. B. Soft Barrier), je nachdem, wie strikt die Synchronisation sein muss.

Fazit

Das Barrier Pattern ist ein nützliches Entwurfsmuster für die Synchronisation von Threads oder Prozessen, insbesondere in parallelen oder verteilten Systemen. Es ermöglicht eine einfache und effektive Koordination zwischen mehreren Entitäten, sodass sie gleichzeitig fortfahren können, wenn alle bereit sind. Das Pattern hat viele Vorteile, darunter die Vermeidung von Race Conditions und die Steigerung der Systemleistung, kann jedoch auch zu Blockierungen und Verzögerungen führen. Die Anwendung des Barrier Patterns erfordert sorgfältige Planung, insbesondere in Systemen mit vielen Threads oder Prozessen, die auf eine gemeinsame Synchronisation angewiesen sind.

barrier pattern

Barrier Pattern vs. Event Groups in FreeRTOS – was ist besser?

Event Groups sind oft effizienter und flexibler, weil du mehrere Bits für verschiedene Tasks oder Ereignisse nutzen kannst. Du kannst damit auch mehrere Barrieren logisch aufbauen. Beispiel: EventBits_t uxBits; uxBits = xEventGroupWaitBits( event_group, TASK1_BIT | TASK2_BIT | TASK3_BIT, pdTRUE, // Clear bits on exit pdTRUE, // Wait for ALL bits portMAX_DELAY); Das ersetzt eine Barrier […]

Barrier Synchronization in FreeRTOS – wie geht das?

FreeRTOS bietet kein direktes Barrier-Primitive. Du kannst aber Barrieren mit Hilfe von Counting Semaphores oder Event Groups bauen. Beispiel mit Counting Semaphore: SemaphoreHandle_t barrier; int barrier_count = 0; void task_func(void *params) { // Vor der Barrier // … Code … xSemaphoreTake(mutex, portMAX_DELAY); barrier_count++; if (barrier_count == NUM_TASKS) { for (int i = 0; i < […]

Wann sollte man das Barrier Pattern verwenden (und wann nicht)?

Verwenden, wenn: Mehrere Tasks einen synchronen „Phasenwechsel“ durchführen müssen. Daten synchronisiert gelesen/verarbeitet werden sollen. Multicore-Tasks bei bestimmten Schritten gemeinsam fortschreiten sollen. Nicht verwenden, wenn: Tasks unabhängig laufen können. harte Echtzeitanforderungen vorliegen – da Wartezeiten unvorhersehbar sind. ein einziger Fehler (z. B. ein hängender Task) die ganze Synchronisation blockieren kann.

Warum bleibt mein Task in der Barrier hängen?

Mögliche Ursachen: Ein Task ist gecrasht oder blockiert, erreicht die Barrier nie → die anderen warten ewig. Fehlender Mutexschutz beim Zählen → Race Condition → barrier_count erreicht nie das Ziel. Zu früh gesetzter Freigabemechanismus, bevor alle Tasks angekommen sind. Nicht symmetrische Anzahl von xSemaphoreGive / Take → Deadlock. Ein Debug-Tipp: In FreeRTOS den Zustand aller […]

Was ist das Barrier Pattern in Embedded Systems?

Das Barrier Pattern ist ein Synchronisationsmechanismus, bei dem mehrere Threads oder Tasks an einem definierten Punkt (der Barrier) warten, bis alle beteiligten Threads diesen Punkt erreicht haben. Erst dann dürfen sie alle gemeinsam fortfahren. Das Ziel ist, eine bestimmte Reihenfolge oder Parallelität zu erzwingen, z. B. vor einer gemeinsamen Operation (wie Datenaustausch oder Phasewechsel).

Wie implementiert man ein Barrier Pattern in C ohne Betriebssystem?

Ohne RTOS implementierst du eine Barrier mit atomaren Operationen oder Interrupt-Sperren zum Schutz kritischer Abschnitte. Beispiel: #define NUM_THREADS 4 volatile int barrier_counter = 0; volatile bool barrier_release = false; void barrier_wait(void) { __disable_irq(); // Kritischer Abschnitt barrier_counter++; if (barrier_counter == NUM_THREADS) { barrier_release = true; } __enable_irq(); while (!barrier_release) { // busy-wait, ggf. sleep/low-power } […]

Zur Liste der Pattern: Liste der Design-Pattern