Man kann kaum noch durch LinkedIn scrollen, ohne von Posts über KI-Agenten überrollt zu werden, die angeblich „kurz vor dem Durchbruch“ stehen. Der Begriff ist plötzlich überall – von Produktmanagern bis zu Tech-Influencern wird er inflationär verwendet. Doch der Großteil dieser Euphorie wirkt vertraut: Sie erinnert an das überzogene Versprechen früherer Tech-Buzzwords wie Web3. Und auch wenn es inzwischen faszinierende Fortschritte gibt, lohnt sich ein genauerer Blick auf das, was KI-Agenten wirklich leisten – und was nicht.

Wie ich schwöre, muss es sich um Bot-Farmen, ignorante nicht-technische Leute und einen fabrizierten Hype von OpenAI handeln, damit sie mehr Geld erhalten können. Ich meine, wie viele Software-Ingenieure kennen Sie, die produktionsreife Agenten freigegeben haben?

Das stimmt. Nichts.

Hier ist der Grund, warum all dieser fabrizierte Hype Unsinn ist.

Was ist ein „KI-Agent“?

Agenten haben eine lange Geschichte innerhalb der künstlichen Intelligenz. In jüngster Zeit, seit der Erfindung von ChatGPT, hat es sich zu einem großen Sprachmodell entwickelt, das so strukturiert ist, dass es autonom logisch denkt und Aufgaben erledigt.

Dieses Modell KÖNNTE mit Reinforcement Learning fein abgestimmt sein, aber in der Praxis neigen die Leute dazu, nur GPT von OpenAI, Google Gemini oder Claude von Anthropic zu verwenden.

Der Unterschied zwischen einem Agenten und einem Sprachmodell besteht darin, dass Agenten Aufgaben autonom erledigen.

Nehmen wir an, ich wollte aufhören, einen externen Datenanbieter dafür zu bezahlen, dass er Fundamentaldaten für US-Unternehmen erhält.

Bei herkömmlichen Sprachmodellen müsste ich Code schreiben, der mit ihnen interagiert. Dies würde wie folgt aussehen:

- Erstellen Sie ein Skript, das die SEC-Website durchsucht, oder verwenden Sie ein GitHub-Repository, um Unternehmensinformationen abzurufen (gemäß der Richtlinie von 10 Anfragen pro Sekunde in den Nutzungsbedingungen)

- Verwenden Sie eine Python-Bibliothek wie pypdf, um die PDFs in Text umzuwandeln

- Senden Sie sie an ein großes Sprachmodell, um die Daten zu formatieren

- Überprüfen der Antwort

- Speichern Sie es in der Datenbank

- Wiederholung für alle Unternehmen

Bei einem KI-Agenten sollten Sie theoretisch nur sagen können.

Scrapen Sie die vergangenen und zukünftigen historischen Daten aller US-Unternehmen und speichern Sie sie in einer MongoDB-Datenbank

Vielleicht stellt es Ihnen einige klärende Fragen. Möglicherweise werden Sie gefragt, ob Sie eine Idee haben, wie das Schema aussehen sollte oder welche Informationen am wichtigsten sind.

Aber die Idee ist, dass Sie ihm ein Ziel geben und er die Aufgabe völlig autonom erledigt.

Klingt doch zu schön, um wahr zu sein, oder?

Das liegt daran, dass es so ist.

Das Problem mit KI-Agenten in der Praxis

Wenn nun das billigste, kleine Sprachmodell kostenlos wäre, so stark wie Claude 3.5, und lokal auf jeder AWS T2-Instanz ausgeführt werden könnte, dann wäre dieser Artikel in einem völlig anderen Ton.

Es wäre keine Kritik. Es wäre eine Warnung.

So wie es aussieht, funktionieren KI-Agenten jedoch nicht in der realen Welt, und hier ist der Grund.

1. Kleinere Modelle sind nicht annähernd stark genug

Das Kernproblem von Agenten besteht darin, dass sie auf große Sprachmodelle angewiesen sind.

Genauer gesagt setzen sie auf ein GOOD-Modell.

GPT-4o mini, das billigste, große Sprachmodell, abgesehen von Flash, ist für den Preis ERSTAUNLICH.

Aber es ist ganz einfach nicht stark genug, um reale Agentenaufgaben zu erledigen.

Er wird ablenken, seine Ziele vergessen oder einfach nur einfache Fehler machen, egal wie gut Sie ihn dazu auffordern.

Und wenn es live eingesetzt wird, wird Ihr Unternehmen den Preis dafür zahlen. Wenn das große Sprachmodell einen Fehler macht, ist er nicht sehr einfach zu erkennen, es sei denn, Sie erstellen auch ein (wahrscheinlich LLM-basiertes) Validierungsframework. Ein kleiner Fehler am Anfang, und alles, was danach nachgelagert ist, ist gekocht.

In der Praxis funktioniert das folgendermaßen.

2. Verschlimmerung von Fehlern

Nehmen wir an, Sie verwenden GPT-4o-mini für agentische Arbeit.

Ihr Agent unterteilt die Aufgabe, Finanzinformationen für ein Unternehmen zu extrahieren, in kleinere Teilaufgaben. Nehmen wir an, die Wahrscheinlichkeit, dass jede Teilaufgabe richtig gemacht wird, beträgt 90 %.

Damit vermehren sich die Fehler. Ist eine Aufgabe mit vier Teilaufgaben auch nur mittelschwer schwierig, ist die Wahrscheinlichkeit, dass das Endergebnis gut wird, extrem gering.

Wenn wir dies zum Beispiel aufschlüsseln:

- Die Wahrscheinlichkeit, eine Teilaufgabe zu erledigen, beträgt 90 %

- Die Wahrscheinlichkeit, zwei Teilaufgaben zu erledigen, beträgt 0,9 * 0,9 = 81 %

- Die Wahrscheinlichkeit, vier Teilaufgaben zu erledigen, liegt bei 66 %

Sehen Sie, wohin ich gehe?

Um dies zu vermeiden, sollten Sie ein besseres Sprachmodell verwenden. Das stärkere Modell kann die Genauigkeit jeder Teilaufgabe auf 99 % erhöhen. Nach vier Teilaufgaben beträgt die endgültige Genauigkeit 96 %. Viel besser (aber immer noch nicht perfekt).

Am wichtigsten ist, dass der Wechsel zu diesen stärkeren Modellen mit einer Kostenexplosion verbunden ist.

3. Kostenexplosion

Sobald Sie zu den stärkeren OpenAI-Modellen wechseln, werden Sie sehen, wie Ihre Kosten explodieren.

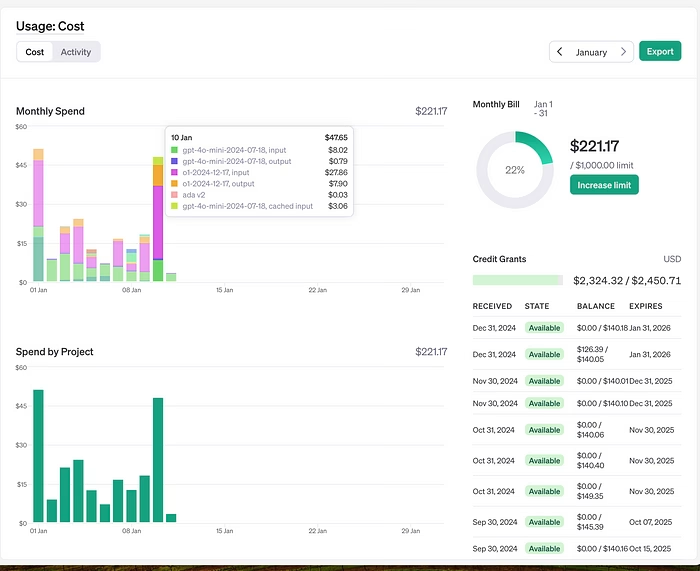

Die rosa und orangefarbene Linie sind die Kosten für OpenAIs o1. Ich verwende es vielleicht 4-5 Mal pro Tag für extrem intensive Aufgaben wie das Generieren syntaktisch gültiger Abfragen für die Aktienanalyse.

Die lindgrüne und dunkelblaue Linie sind GPT-4o-mini. Bei diesem Modell werden täglich Hunderte von Anfragen bearbeitet, und die endgültigen Kosten betragen nur einen kleinen Bruchteil dessen, was O1 kostet.

Darüber hinaus müssen Sie auch nach all dem noch die endgültige Ausgabe validieren. Aus den gleichen Gründen werden Sie die stärkeren Modelle für die Validierung verwenden.

Sie verwenden also größere Modelle für den Agent, und Sie verwenden größere Modelle für die Validierung.

Siehst du, warum ich denke, dass es sich um eine OpenAI-Verschwörung handelt?

Und schließlich hat die Veränderung der Welt von der Arbeit mit Code hin zur Arbeit mit Modellen massive Nebenwirkungen.

4. Sie erstellen Arbeiten mit nicht-deterministischen Ergebnissen

Mit LLM-Agenten verschiebt sich das gesamte Paradigma Ihrer Arbeit in einen datenwissenschaftlichen Ansatz.

Anstatt deterministischen Code zu schreiben, der überall kostengünstig ausgeführt werden kann und auf einem Arduino (oder in der Praxis auf einer T2-Mikroinstanz von AWS) ausgeführt werden kann, schreiben Sie nicht-deterministische Eingabeaufforderungen für ein Modell, das auf einem Cluster von GPUs ausgeführt wird.

Wenn Sie „Glück“ haben, betreiben Sie Ihre eigenen GPUs mit fein abgestimmten Modellen, aber es wird Sie immer noch einen Arm und ein Bein kosten, nur um Agenten für einfache Aufgaben zu halten.

Und wenn Sie Pech haben, sind Sie vollständig an OpenAI gebunden; Ihre Eingabeaufforderungen funktionieren nicht, wenn Sie versuchen, sich zu bewegen, und sie können den Preis langsam erhöhen, da Sie kritische Geschäftsprozesse über ihre APIs ausführen.

Und bevor Sie sagen: „Sie können OpenRouter verwenden, um das Modell einfach zu wechseln“, denken Sie noch einmal darüber nach. Die Ausgabe des Anthropic-Modells unterscheidet sich von der Ausgabe von OpenAI.

Sie müssen also Ihren gesamten Stack neu entwickeln, was ein Vermögen kostet, nur um eine marginale Verbesserung der endgültigen Leistung für einen anderen LLM-Anbieter zu erzielen.

Sehen Sie, was das Problem ist?

Fazit

Es scheint fast sicher zu sein, dass, wenn ich einen Beitrag über Agenten sehe, er von jemandem stammt, der in der Praxis keine Sprachmodelle verwendet hat.

Wie Sie sich vorstellen können, ist das absolut ärgerlich.

Ich sage nicht, dass KI keine Anwendungsfälle hat. Sogar Agenten können in ein paar Jahren einen Wert haben, um Ingenieure beim Schreiben von einfachem Code zu unterstützen.

Aber kein vernünftiges Unternehmen wird sein Betriebsteam durch eine Reihe extrem teurer, fehleranfälliger Agenten ersetzen, um kritische Prozesse für sein Unternehmen auszuführen.

Und wenn sie es versuchen, werden wir alle mit eigenen Augen sehen, wie sie in zwei Jahren bankrott gehen. Sie werden eine Lektion in den Wirtschaftslehrbüchern sein, und OpenAI wird zusätzliche 1 Milliarde US-Dollar Umsatz machen.

Weiterer Beitrag für Sie: Python-Skripte um 300% beschleunigen